2025年4月にローカル環境で1枚の画像から高品質な動画を最大120秒まで作成できる「FramePack」というAI動画生成ツールが出てきました。

「FramePack」は、わずか6GBのVRAMで120秒の高品質AI動画が生成できる革新的技術です。

以前のAI動画生成ツールは、ある程度の品質を求めるとWebサービスを利用するしかなかったのですが「FramePack」はローカル環境でも高品質な動画を作成することができます。

上の画像はChatGPTで出力した女性の画像です。

女性が立っているだけの何の変哲もない画像ですが・・・

この1枚の画像を使用して「FramePack」でAI動画生成するとこのような動画が作成できます!

女性に動きが加わることで、見違えるように魅力的に見えるようになりました!!

これならネットなどで手に入れた綺麗なイラスト画像を動かしてみたくなりますよね!!!

ミニPCで「FramePack」を動かすことはできるのか?

「FramePack」の必要要件は以下の3点です。

- Nvidia GPU in RTX 30XX, 40XX, 50XX series that supports fp16 and bf16. The GTX 10XX/20XX are not tested.

- Linux or Windows operating system.

- At least 6GB GPU memory.

要約するとNvidia RTX30XX、40XX、50XXシリーズのグラフィックカードでビデオメモリ(VRAM)6GB以上の製品。LinuxかWindowsのOSを使用していること。となります。

「なんだ、RTX3070 8GBなら余裕じゃね!!」と思れる方がいるかもしれませんが、実際「FramePack」を使ってみると分かりますがとんでもなくPCパワー(グラフィック性能)を使います。

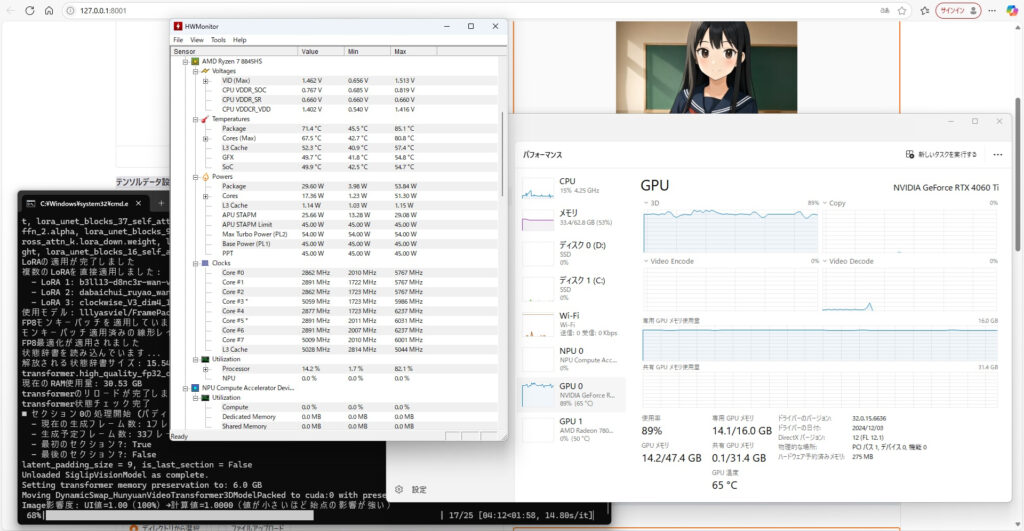

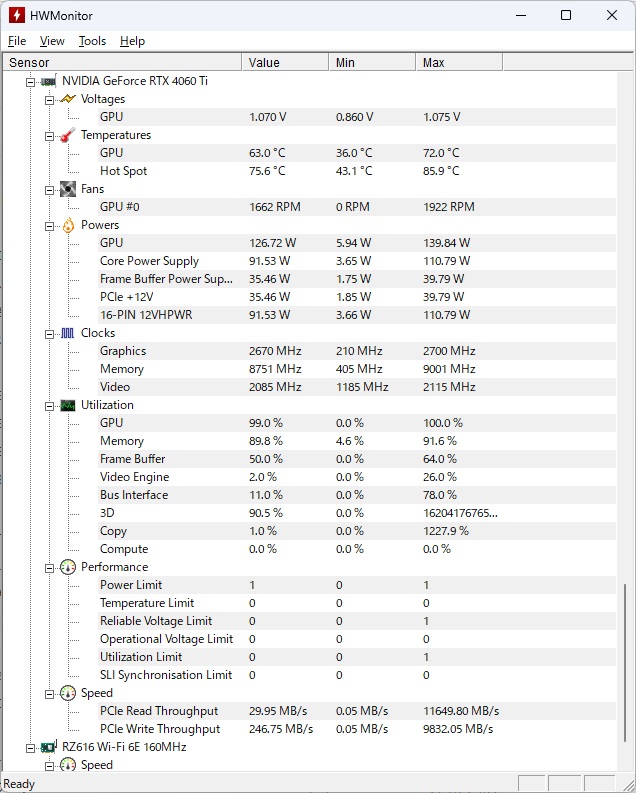

「FramePack」のAI動画生成中はグラフィックカード(GPU)の使用率がほぼ100%(正確には90%台後半)になります。

しかもグラフィックメモリ(VRAM)も搭載している最大容量まで使用し、生成処理にVRAMが足りない場合はメインメモリを大量に消費してしまいます。

また解像度が高く、かつ高品質なAI動画を作成したい場合はVRAMが16GB以上のグラフィックカードが必須になります。

「FramePack」はわずか6秒間のAI生成動画を作成するのに最新のグラフィックカードを使用しても10~20分近く時間が掛かるというとても高負荷な処理を必要としています。。

なのでエントリーGPU程度の性能しかないミニPC(APU)の内蔵GPUで、AI動画生成を行うのは可能性としてできなくはないとは思いますが生成処理に何時間も掛かってしまい作業を行うにはあまり現実的ではありません。

そのうえAPUを何時間もフル稼働していてはミニPC内の排熱が追い付かず直ぐに故障してしまう懸念もあります。

「FramePack」はグラフィック性能を最大まで使用しますが、CPU性能は10%前後しか実際は使用していません。

今までの話をまとめると、「FramePackの動作は、CPUはそこそこの性能の製品で構わないがグラフィックカード(GPU)の性能は極限まで必要とする」ので、視点を変えてみると「CPU部分はミニPCに任せてグラフィックカード(GPU)部分は外付けGPUでグラフィック性能を賄(まかな)えば問題無い」と考えることができます。

これが何を意味しているかというと・・・・

ここで外付けGPUキット「Minisforum DEG1」の出番です!!

これは、CPU部分は負荷が軽いためミニPC本体に任せて、高負荷のグラフィック部分は外付けGPUに処理を投げてしまおうという発想です。

ミニPCとグラフィックカードをUSB4より高速なOCuLink接続で繋げるアダプターとして、「Minisforum DEG1」が発売されています。

詳しくは以下の記事で説明しています。

ミニPCに外付けGPUキットの「Minisforum DEG1」を接続する

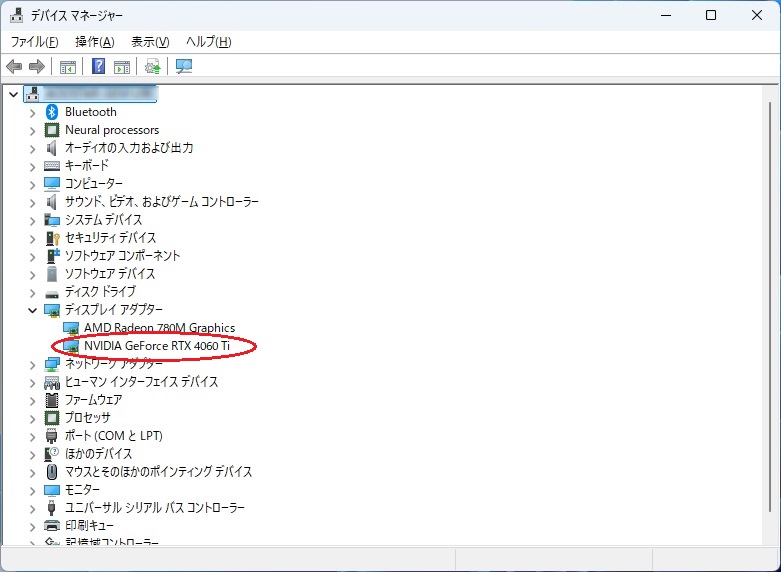

「Minisforum DEG1」と組み合わせるグラフィックカードは、今回「Nvidia GeForce RTX 4060 Ti 16GB」を使用します。

高品質なAI動画生成を行うのにはVRAMが最低でも16GB以上必要です。現在の生成AI界隈では「VRAMが全て」といっても過言ではありません。

そしてなぜ最新のRTX50XXではないかというと、2025年6月現在では「FramePack」はRTX50XXの高速化に全て対応できておらず、「FramePack」を動作させるのに「CUDAバージョン」や「Pytorchバージョン」を対応したものに置き換えたり、プログラムを書き換えたりと知識が無い方には非常に敷居が高い状態になっているからです。

その点RTX40XXシリーズはワンタッチに近い感覚で手軽に「FramePack」をインストールして簡単に動作させることができます。

そしてVRAM 16GB以上を搭載したRTX40XXシリーズは「RTX 4060ti 16G」「RTX 4070TiS」「RTX4080」「RTX4080Super」「RTX4090」の6モデルしかなく、「RTX 4070TiS」以上の価格は中古でも軒並み12万円以上するという状況です。

そんな中で唯一中古で6万円前後で購入できるのが「RTX 4060ti 16G」になります。

とあるフリーマーケットで手頃な「RTX 4060ti 16G」を購入しました。

生成AIの世界では「VRAM 16GB」はとても魅力的です!!

ファンが2個の製品ですね。

使用感が少なく、美品に見えます。

「RTX 4060ti 16G」を「Minisforum DEG1」に取り付けます。

そしてミニPCへ接続します。

使用するミニPCは「Aoostar GEM12」のメモリ容量を64GBへ増量したものになります。

ミニPCのメインメモリを増設した布石がここで生きてきましたよ!!

ミニPC用の「SO-DIMM DDR5 5600MHz PC5-44800 32GBx2枚組 64GBキット」は安く購入できるようになってきましたので、ミニPCをお持ちの方はこの際増設しちゃいましょう!

「FramePack」はメインメモリ(RAM)を最低でも32GB以上必要とします。

生成AIを扱うならメインメモリは最低でも64GBあった方が良いでしょう。

↓今回使用したミニPCの後継機種です。

「Minisforum DEG1」の電源をONにしてからミニPCの電源を入れてwindowsを立ち上げます。

Nvidiaのグラフィックドライバは安定している「566.36」のバージョンをインストールしました。

RTX4060ti 16GBはWindowsにしっかり認識されています!

VRAM 16GBは正義!!

「FramePack」を導入する

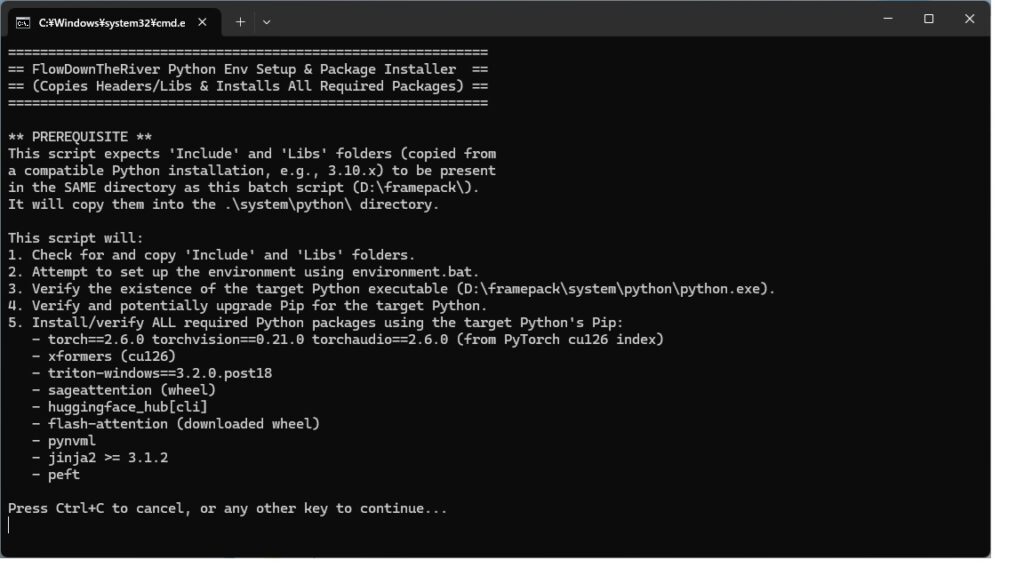

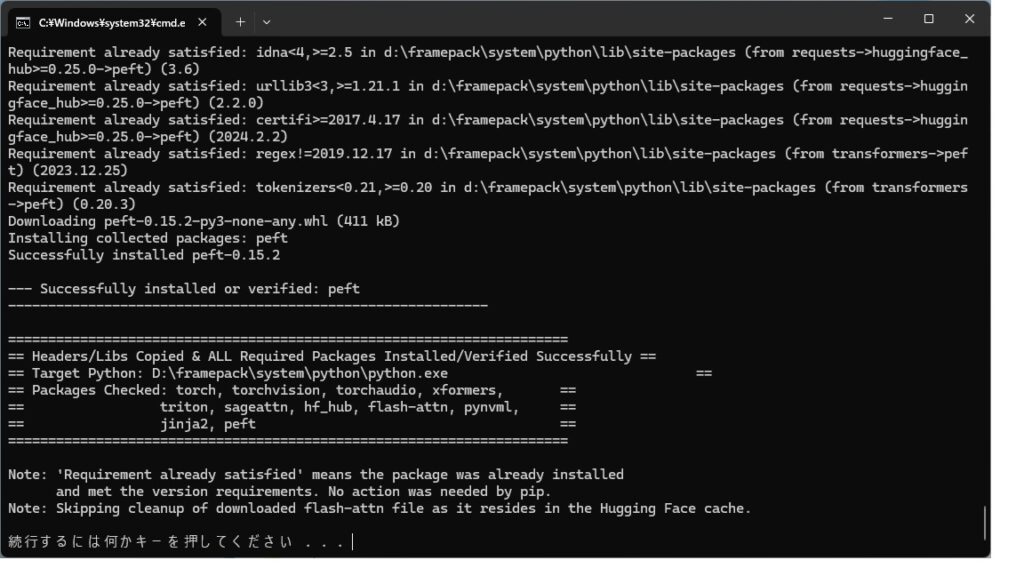

RTX40XXシリーズであれば「Python」など特別なプログラムの知識が無くても簡単に「FramePack」を導入することができます。

「Xformers、Flash Attn、Sage Attn」などの高速化モジュールもクリックしていくだけで導入できます。

「mod_package_installer_unified.bat」アイコンと、立ち上がったコマンドプロンプトの処理開始のためのクリックの合計2クリックで高速化モジュールが導入できてしまいました。

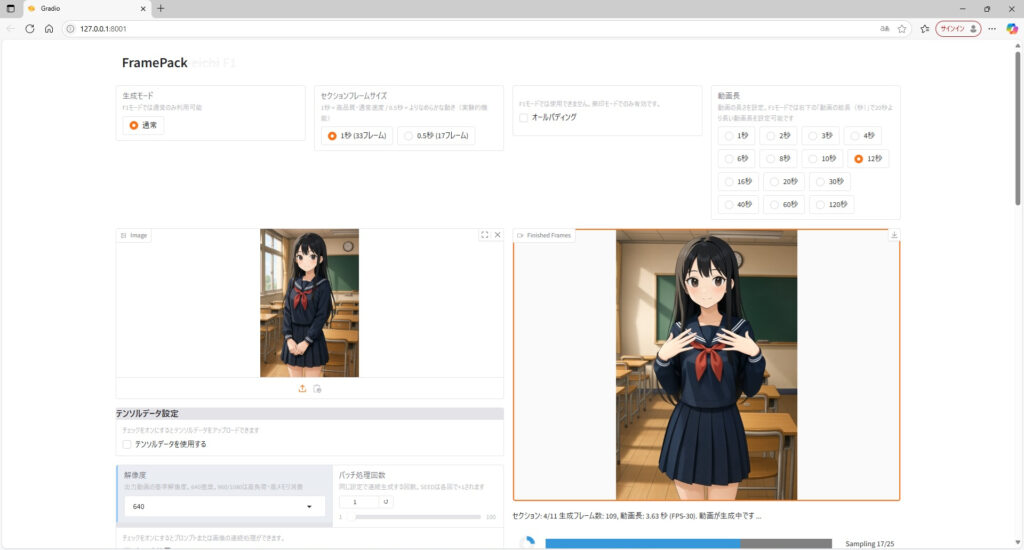

「FramePack-eichi」でAI動画生成をやってみた

ついでに「FramePack」の機能拡張版である「FramePack-eichi」も導入しちゃいましょう!!

画像の素材はChatGPTさんに出力してもらった女の子の画像を使ってみました。

「踊り」と「カメラワーク」に関するLoRAを使用してプロンプトを入力します。

解像度はデフォルト設定の640で始めます。

AI動画生成中はグラフィックカードがフルに動きます。

グラフィックカードの使用率が軒並み90%台で、VRAMは14GBまで使用しています。

メインメモリはLoRA読み込み中は48GB近くまで使いますが、生成が始まると33GB程度まで使用率が下がります。

ミニPCの設定はTDP35Wの静音設定に下げて使用すると、ミニPC自体のファンの音がとても静かになりました。

CPU(APU)の使用率は10~20%台で、CPU温度は70℃前後と十分冷却ができています。

RTX4060ti 16GBはそれほど性能は高くないグラフィックカードです。

それが奏功してGPU使用率90%台でも温度が60℃台に収まっており、GPUファンも1600RPM前後と静音性が保たれておりファンが唸るようなことは一切ありません。

RTX4060ti 16GBの消費電力は130W程度とワットパフォーマンスが非常に優れています。

ミニPC+RTX4060ti 16GBのシステム全体の消費電力が合計200W未満の省エネのAI動画生成環境が誕生しました!!

いまどきのRTX5080など搭載したゲーミングPCで「AI動画生成」をやろうとしたら、消費電力がRTX5080だけでも350W以上するため、システム全体だと500W以上になってしまいます。

ゲーミングPCを使って「AI動画生成」作業中はPCゲームが一切できません!!

私も先日「RTX5070ti」のPCを組み立てましたが、PCゲーム用として使用しています。

その点、サブ用としてOCuLink端子を搭載したミニPCをお持ちの方は、「Minisforum DEG1」+「RTX4060ti 16GB」を追加するだけでAI動画生成を快適に行うことができます。

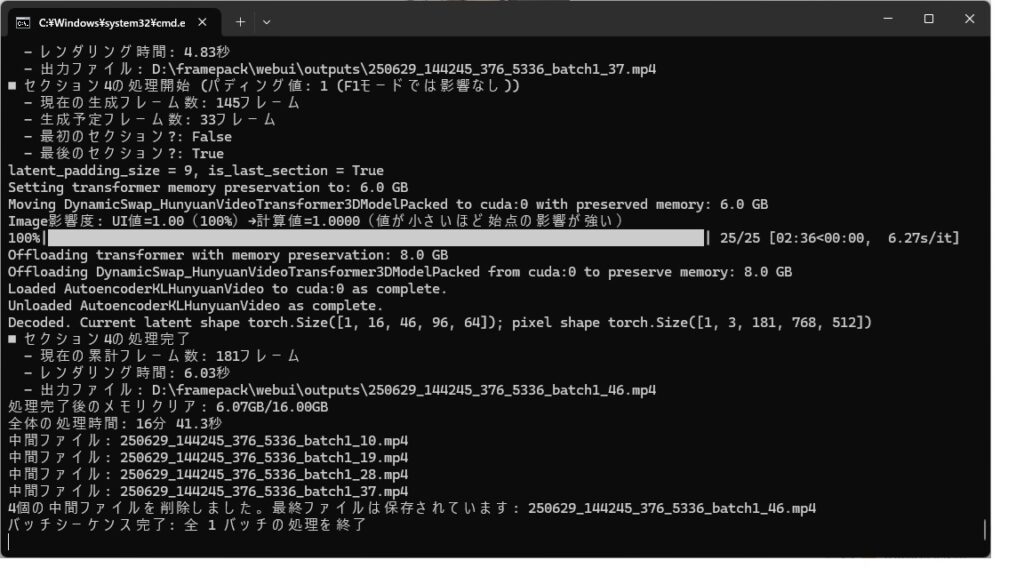

「RTX4060ti 16GB」で6秒のAI動画生成を行うのに16分41秒でした。

12秒のAI動画生成だと2倍の32~33分程度の時間かかります。

この程度の時間であればサブPC(ミニPC+Minisforum DEG1+RTX4060ti 16GB)へ処理を投げて放置しておけば気にならないと思います。

背景も連動して動くと臨場感も上がりますね!!

生成したAI動画を「fluidmotion機能」で144fps化!!

生成したAI動画は「FramePack-eichi」のデフォルト設定ではフレームレートが30fpsになっています。

ここで私は頭の中に閃光が走りました・・・

生成した30fpsのAI動画はVEGAコアを搭載したAPUやグラフィックカードの「fluidmotion」のフレーム補間機能を利用すれば144fpsの滑らかな動画として再生できるのではないか・・・

「fluidmotion」については下記の記事を参照してください。

生成したAI動画を「Ryzen7 5700G搭載のセカンドPC」の「MPC-BEプレーヤー」で再生してみました。

よしっ!144fpsにフレーム補間されて滑らかに動いています!!

「AI動画生成」+「fluidmotion」の組み合わせは最強でした!

こちらの記事も合わせて読んでね!

コメント